2018年11月19日,【统计学论坛】在清华大学伟清楼209成功举办。报告邀请到北京大学数学科学学院的艾明要教授。本次报告由清华大学统计学研究中心邓柯教授邀请,俞声教授主持。报告的主题是“Optimal Subsampling Algorithm for Big Data Generalized Linear Models”。

报告开始,艾教授首先通过两个例子:The Gas Sensor Array Drift Data Set和The Echo Nest Taste Profile Subset为我们引入了具有典则联结函数的广义线性模型。但传统的利用Newton-Raphson方法求最大似然估计时,由于迭代次数多,计算复杂,并不适用于当今大数据的时代背景。

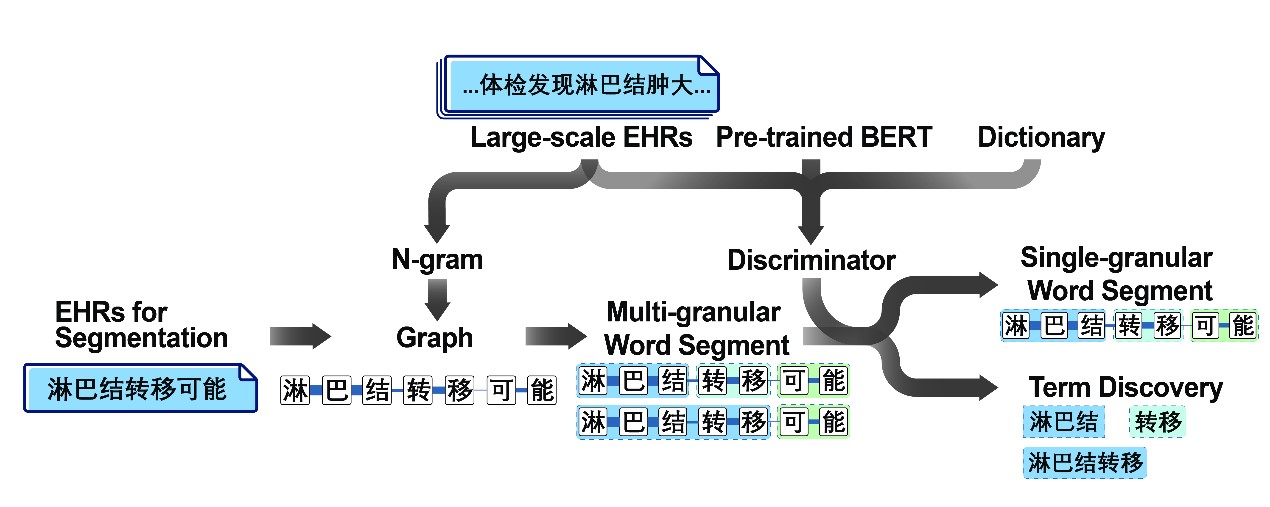

所以艾教授的团队提出了使用抽样的算法,其基于Wang et al.(JASA, 2017)提出的应用于logistic regression model的Optimal Subsampling Method under the A-optimality Criterion (OSMAC)方法,将其推广到广义线性模型中,并分别推导了其估计量在大样本和有限样本下的性质。基于大样本下的渐近正态性,可以将目标转化为使得方差的迹tr(

)(等于

的渐进MSE)达到最小,求得最优概率

,为使计算更加简便,还引入了

,由于

与

无关,从而可以简化为使tr(

达到最小,求得最优概率

。艾教授随后针对提出的方法分别进行了模拟和应用实例验证。展示了该算法对于大型数据集在计算上的可行性,同时证明了选择不同概率进行抽样比等概率抽样更加有效。