为了贯彻落实《中华人民共和国国民经济和社会发展第十三个五年规划纲要》和《促进大数据发展行动纲要》,积极响应国务院办公厅《关于促进和规范健康医疗大数据应用发展的指导意见》和人社部关于医保目录准入谈判的新举措,清华大学统计学研究中心医疗大数据中心携手国家卫生健康委员会卫生技术评估重点实验室(复旦大学)于2018年4月14日在京举行“医疗大数据与卫生技术评估论坛”。

近年来,大数据发展受到社会的广泛关注。医疗大数据,以其规模大、数据结构复杂,和多样性来源的特点,为健康产业带来了新的机遇与挑战。2017年医保目录调整,首次引入医保目录准入谈判机制,为我国的卫生技术评估提出了新的目标和要求。为了积极支持健康中国的建设,本次会议将围绕医疗大数据与卫生技术评估在中国的发展与前景,国际前沿发展与趋势,相关领域的创新研究,并紧密结合实际案例为与会者提供交流、分享的平台。

会议主题:医疗大数据与卫生技术评估的发展与展望,为健康中国助力

会议时间:2018年4月14日 8:30-17:30

签到时间:2018年4月14日 8:00-8:30

会议地点:文津国际酒店(地址:北京市海淀区成府路清华大学南门)

会议日程:

| 时 间 | 报告人 | 报告题目 |

| 08:30-08:40 | 林希虹 教授 哈佛大学 |

致开幕词 |

| 08:40-09:10 | 熊先军 书记 人力资源和社会保障部 社会保险事业管理中心 |

关于卫生经济学在医保应用的 思考 |

| 09:10-09:40 | 王永雄 教授 斯坦福大学 美国科学院院士 |

关于电子病历在精准医学研究中的几点思考 |

| 09:40-10:10 | 刘国恩 教授 北京大学 |

经济增长与健康中国 |

| 10:10-10:40 | 合影&茶歇 | |

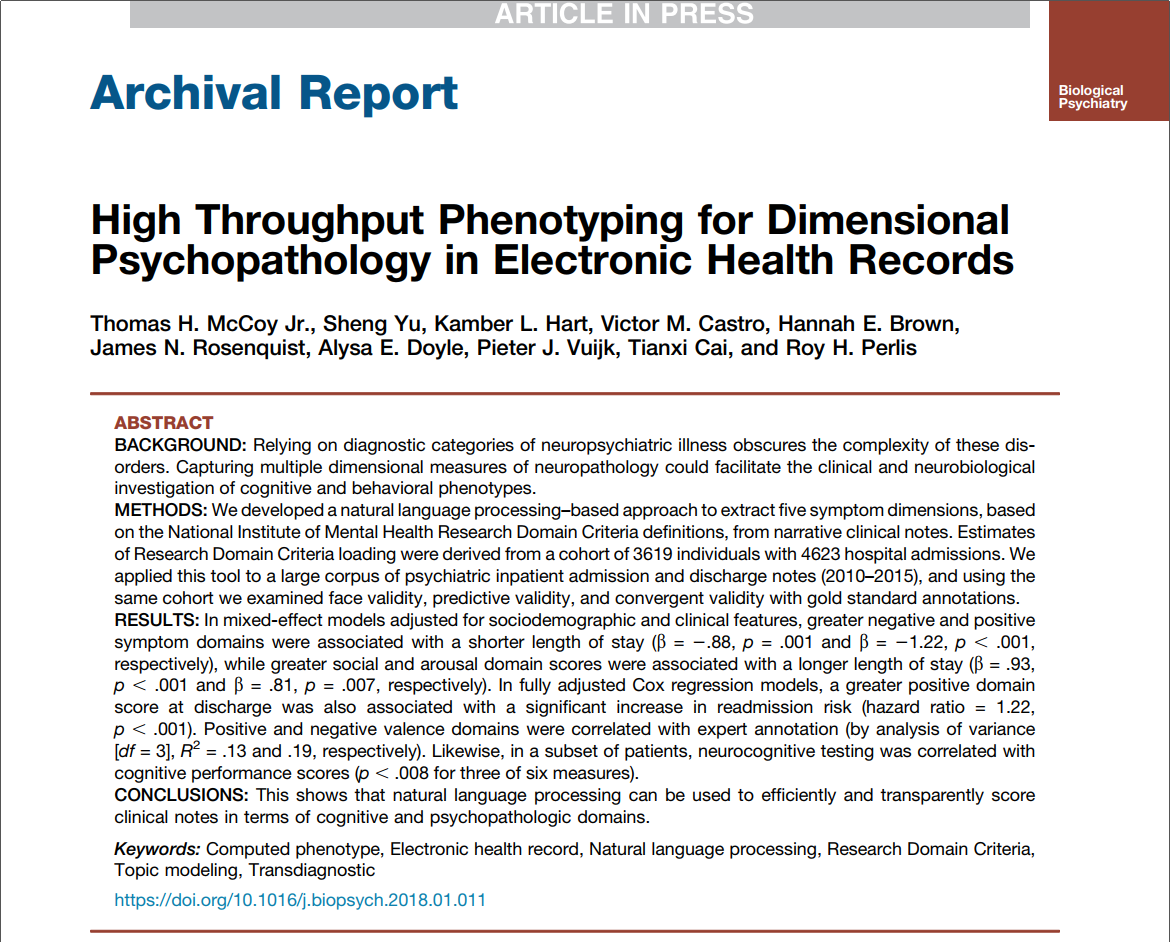

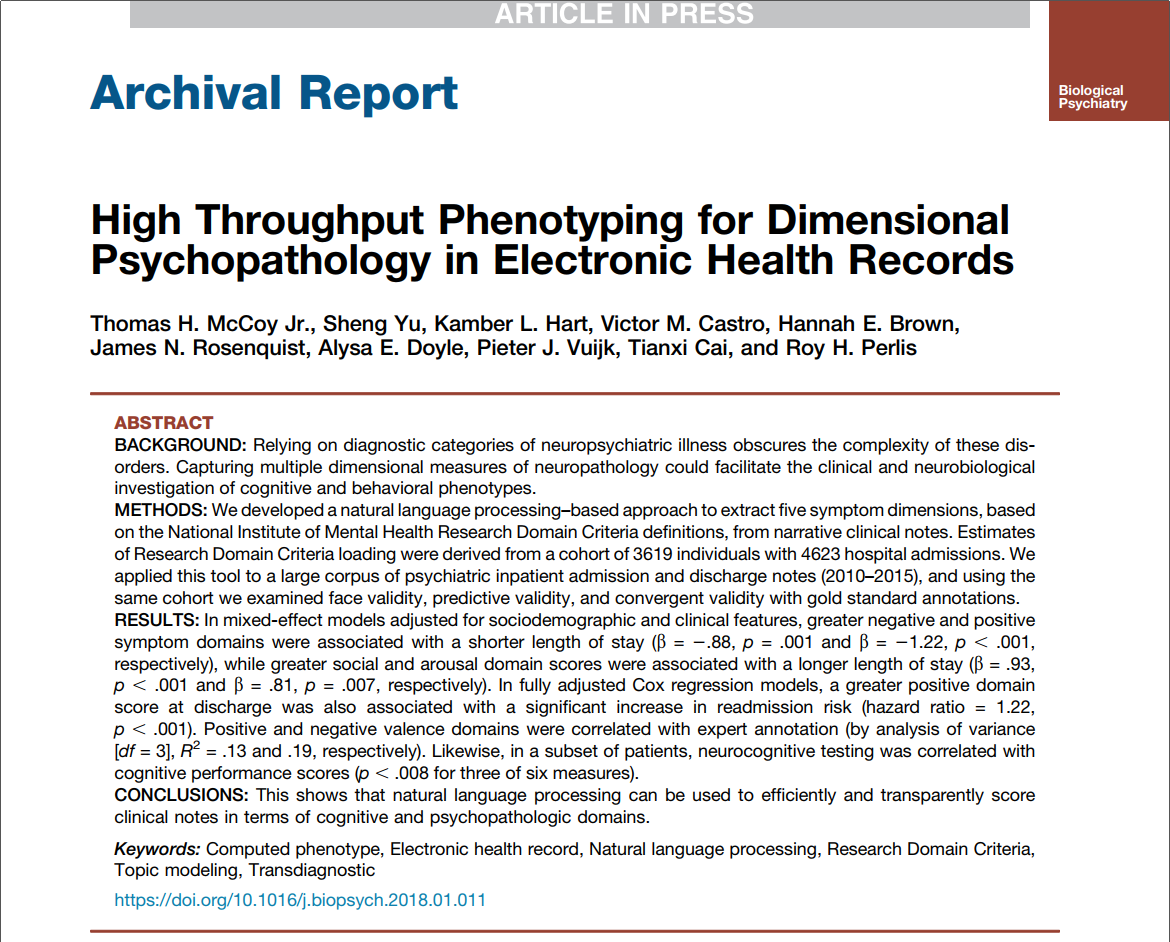

| 10:40-11:10 | 邓 柯 副教授 清华大学 |

医学自然语言处理的统计学方法 |

| 11:10-11:40 | 吴 琼 博士 Analysis Group |

识别最优目标人群及其在卫生技术评估中的应用 |

| 11:40-12:10 | 陈英耀 教授 复旦大学 |

中国卫生技术评估发展现状和 机遇 |

| 13:30-14:00 | 王 杉 教授 北京大学人民医院 |

明日医疗—大数据时代医院之机遇和挑战 |

| 14:00-14:30 | 张学工 教授 清华大学 |

对未来医疗的若干技术和策略探讨 |

| 14:30-15:00 | 肖 辉 首席应用官 中电数据服务有限公司 |

做好健康医疗大数据安全保障工作 |

| 15:00-15:20 | 茶 歇 | |

| 15:20-15:50 | Praveen Thokala 博士 英国谢菲尔德大学 |

Health Technology Assessment in UK |

| 15:50-16:20 | 王亚东 教授 哈尔滨工业大学 |

组学数据的有效利用 |

| 16:20-16:50 | 韩思蒙 博士 Analysis Group |

医疗大数据在真实世界中的应用 |

| 16:50-17:20 | 施李正 教授 杜兰大学 |

圆桌讨论 |

| 吴 晶 教授 天津大学 |

||

| 肖革新 副主任 国家食品安全风险评估中心 风险监测部 |

||

| 其他嘉宾 | ||

| 17:20-17:30 | 陈英耀 教授 复旦大学 |

致闭幕词 |

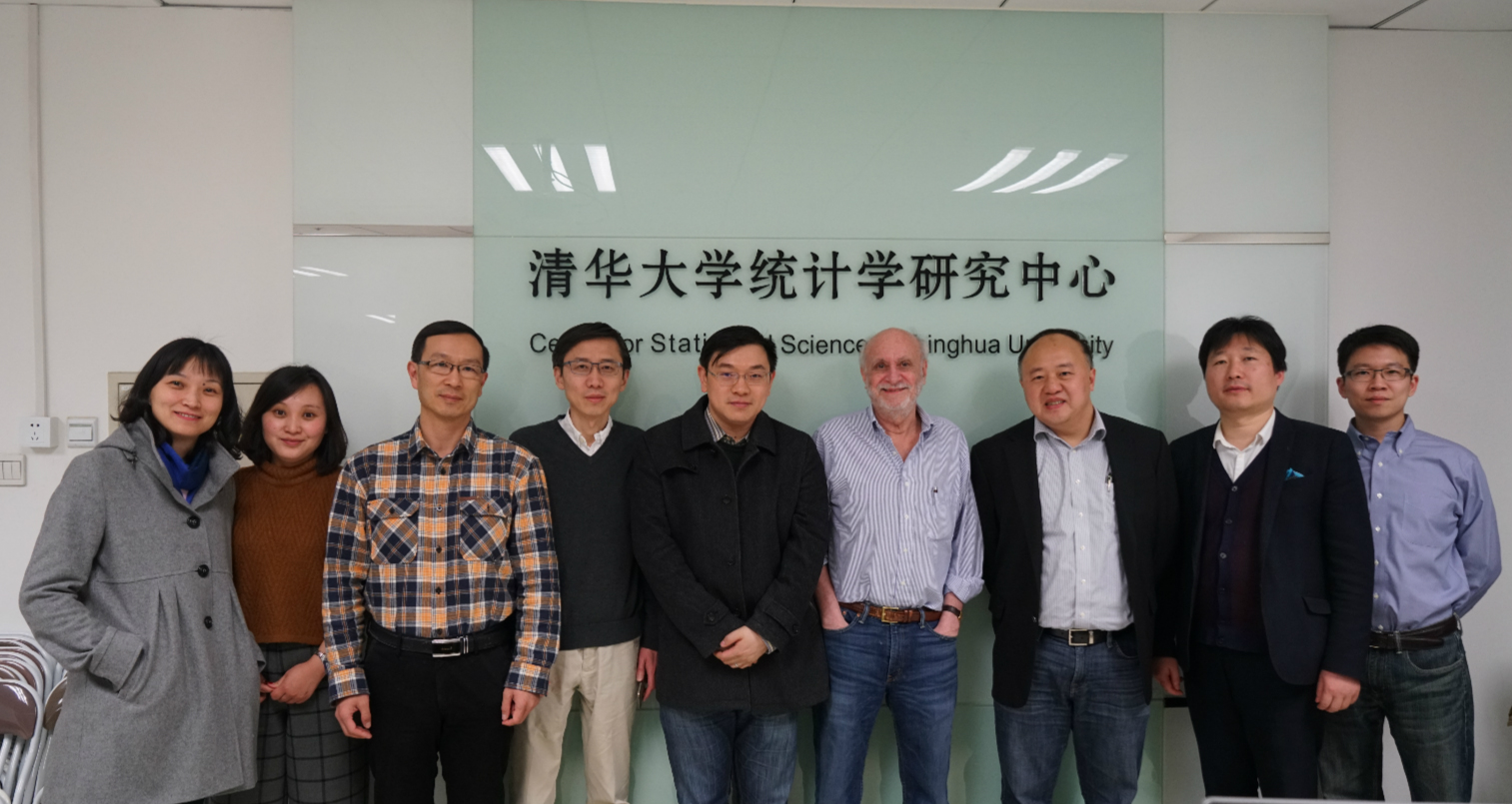

主办单位:

清华大学统计学研究中心医疗大数据中心

国家卫生健康委员会卫生技术评估重点实验室(复旦大学)

协办单位:Analysis Group